Ile pamięci RAM potrzebuje skrypt Python do przetwarzania milionów rekordów CSV?

- Ile pamięci RAM potrzebuje skrypt Python przetwarzający milion rekordów CSV?

- Kluczowe czynniki wpływające na zużycie RAM przy milionie rekordów CSV

- Kiedy „wszystko na raz” nie działa: techniki oszczędzania pamięci

- Jak oszacować i zmierzyć zużycie pamięci przy milionie rekordów

- Przykład: milion transakcji w CSV i różne scenariusze

- Podsumowanie: ile RAM faktycznie potrzebuje skrypt Python dla miliona rekordów CSV?

Ile pamięci RAM potrzebuje skrypt Python przetwarzający milion rekordów CSV?

Ile pamięci RAM potrzebuje skrypt Python przetwarzający milion rekordów CSV? To pytanie wraca jak bumerang u osób, które zaczynają pracę z większymi plikami danych. W dobie wszechobecnych logów, transakcji czy danych telemetrycznych, wydajne przetwarzanie CSV w Pythonie staje się kluczową umiejętnością.

Nie chodzi tylko o to, czy skrypt zadziała, ale czy nie „zabije” komputera przez nadmierne zużycie RAM. Przy milionie rekordów bardzo łatwo przejść od „wszystko działa” do MemoryError lub nieakceptowalnie wolnego działania. Dlatego warto rozumieć, skąd bierze się zużycie pamięci.

Nie ma jednej magicznej liczby, typu „milion rekordów = 2 GB RAM”. Zużycie pamięci zależy od rodzaju danych, sposobu ich ładowania oraz wykorzystywanych struktur danych i bibliotek. Dobra wiadomość jest taka, że większość problemów z pamięcią można złagodzić prostymi technikami.

W tym przewodniku zobaczysz, od czego zależy ilość potrzebnej pamięci, jak działa przetwarzanie strumieniowe, jak używać Pandas w trybie oszczędnym oraz jak szacować i mierzyć pamięć zamiast zgadywać „na oko”.

Kluczowe czynniki wpływające na zużycie RAM przy milionie rekordów CSV

Zużycie pamięci przez skrypt Python przetwarzający CSV zależy od kilku głównych obszarów. To trochę jak z pytaniem, ile paliwa zużyje auto na 100 km – bez szczegółów o samochodzie i trasie nie ma jednej odpowiedzi.

Rozmiar i typ danych w pojedynczym rekordzie

Milion rekordów to tylko liczba. W praktyce kluczowe jest to, co dokładnie zawiera jeden rekord. Zupełnie inaczej liczy się pamięć dla prostych liczb, a inaczej dla długich opisów tekstowych.

Najważniejsze elementy:

- Liczba kolumn – im więcej pól, tym więcej danych do przechowania w RAM.

- Typ danych:

intifloatsą zazwyczaj znacznie lżejsze niż długiestr.- Pythonowe stringi mają spory narzut (metadane, referencje itp.).

- Kardynalność (liczba unikalnych wartości):

- Kolumny z powtarzającymi się wartościami (np. województwo, kod kraju) można efektywnie przechowywać jako typ kategorialny.

Przykładowo rekord id,nazwisko,opis_produktu,data_transakcji,kwota będzie zużywał dużo więcej pamięci niż prosty id,cena. Szczególnie pola typu opis_produktu potrafią „spuchnąć” w RAM, jeśli są długie i unikalne.

Sposób ładowania i przetwarzania danych

To jeden z najważniejszych czynników. Ten sam plik CSV może zużywać drastycznie różne ilości pamięci w zależności od tego, jak go wczytasz i przetworzysz.

Możliwe podejścia:

- Wszystko naraz do pamięci (in‑memory):

- Załadowanie całego pliku do listy list, listy słowników lub pełnego DataFrame Pandas.

- Proste w implementacji, ale niebezpieczne dla dużych plików – pamięć może „eksplodować”.

- Przetwarzanie strumieniowe (streaming):

- Czytanie pliku wiersz po wierszu lub w małych partiach.

- Wymaga odrobiny więcej logiki, ale jest znacznie bardziej pamięciooszczędne.

- Wybór biblioteki:

- Moduł standardowy

csvnadaje się świetnie do strumieniowego czytania linii. - Pandas domyślnie ładuje całość, ale oferuje

chunksizedo przetwarzania w kawałkach.

Jeśli wczytujesz milion rekordów „na raz”, Python często zużyje wielokrotnie więcej RAM niż rozmiar samego pliku na dysku. W trybie streamingowym możesz zejść do zużycia rzędu pojedynczych lub kilkudziesięciu megabajtów.

Struktury danych wykorzystywane w skrypcie

Równie ważne jest to, w jakiej postaci trzymasz dane w pamięci. Pythonowe obiekty są dość ciężkie w porównaniu z niskopoziomowymi typami z języków takich jak C.

Kilka istotnych różnic:

- Listy:

- Przechowują referencje do obiektów, a nie dane same w sobie.

- Rezerwują dodatkowe miejsce na przyszłe elementy.

- Słowniki (

dict): - Są bardzo wygodne, ale pamięciożerne (haszowanie, tablice wewnętrzne).

- Tymczasowe zmienne i kopie:

- Każda kopia listy czy DataFrame, każdy pośredni obiekt to dodatkowa pamięć.

- Łatwo „przepalić” RAM przez niepotrzebne tworzenie nowych struktur.

To oznacza, że ta sama ilość surowych danych CSV może być przechowywana z dużo mniejszym narzutem w numpy.array niż np. w liście słowników.

Wersja Pythona i środowisko wykonania

Na zużycie pamięci wpływa także wersja Pythona i system operacyjny. Nowsze wersje Pythona 3 często wprowadzają usprawnienia zarządzania pamięcią, zwłaszcza dla stringów i małych obiektów.

Dodatkowo:

- Interpreter Pythona sam w sobie zajmuje istotną ilość RAM.

- System operacyjny wpływa na sposób alokacji i raportowania pamięci.

- Zewnętrzne biblioteki (np. Pandas, NumPy) dodają własny narzut.

Zwykle jednak największą różnicę robi sam sposób pracy z danymi, a nie konkretna wersja systemu.

Kiedy „wszystko na raz” nie działa: techniki oszczędzania pamięci

Jeśli wczytanie miliona rekordów CSV kończy się brakiem pamięci lub ogromnym spowolnieniem, potrzebujesz zmiany podejścia. Zamiast próbować „upchnąć wszystko”, warto pracować bardziej strumieniowo i świadomie korzystać z bibliotek.

Strumieniowe przetwarzanie danych (czytanie wiersz po wierszu)

Najbezpieczniejszym podejściem przy dużych plikach jest przetwarzanie liniowe, bez trzymania całej zawartości w pamięci. Da się to zrobić już samym modułem csv:

import csv

def process_large_csv_stream(file_path):

record_count = 0

with open(file_path, 'r', encoding='utf-8') as f:

reader = csv.reader(f)

header = next(reader) # Pomijamy nagłówek

for row in reader:

# Operacje na pojedynczym rekordzie (row)

record_count += 1

if record_count % 100000 == 0:

print(f"Przetworzono {record_count} rekordów...")

print(f"Zakończono przetwarzanie. Łącznie: {record_count} rekordów.")

W tym podejściu w pamięci znajduje się tylko jeden wiersz na raz, co radykalnie ogranicza zużycie RAM. Jest to idealne, jeśli:

- Przetwarzasz dane i zapisujesz je np. do bazy lub innego pliku.

- Nie potrzebujesz jednoczesnego dostępu do wszystkich rekordów.

- Wystarczą Ci agregacje, które można aktualizować inkrementalnie (sumy, liczniki itp.).

Biblioteki zoptymalizowane pod kątem pamięci: Pandas i NumPy

Gdy potrzebujesz bardziej złożonej analizy (filtrowanie, grupowanie, agregacje), moduł csv może być niewygodny. Wtedy Pandas i NumPy są naturalnym wyborem – ale trzeba ich używać rozsądnie.

Pandas z chunksize – ładowanie w kawałkach

Choć Pandas kojarzy się z ładowaniem wszystkiego naraz, oferuje tryb „ładowania po kawałku” dzięki parametrowi chunksize:

import pandas as pd

def process_csv_in_chunks(file_path, chunk_size=100000):

total_records = 0

for chunk in pd.read_csv(file_path, chunksize=chunk_size):

# Operacje na fragmencie danych (chunk)

total_records += len(chunk)

print(f"Przetworzono kolejny chunk. Łącznie: {total_records} rekordów.")

print(f"Zakończono przetwarzanie. Łącznie: {total_records} rekordów.")

Każdy fragment (chunk) to osobny DataFrame, który istnieje w pamięci tylko chwilowo. To pozwala:

- Przetwarzać bardzo duże pliki przy ograniczonej pamięci.

- Zachować wygodę operacji Pandas na mniejszych wycinkach danych.

- Ograniczyć zużycie RAM do rozmiaru jednego chunka, a nie całego pliku.

Optymalizacja typów danych w Pandas

Kiedy już masz DataFrame, można drastycznie zmniejszyć jego rozmiar, dopasowując typy kolumn:

- Dla liczb:

- Stosuj

int8,int16,float32zamiast domyślnychint64ifloat64, jeśli zakres wartości na to pozwala. - Dla tekstu:

- Zamieniaj kolumny z powtarzającymi się wartościami na

category. - Dzięki temu wartości są reprezentowane jako liczby, a słownik unikalnych stringów jest przechowywany tylko raz.

Przykładowa procedura:

df = pd.read_csv('milion_rekordow.csv')

print("Zużycie pamięci przed optymalizacją:")

print(df.info(memory_usage='deep'))

for col in df.select_dtypes(include=['object']).columns:

num_unique_values = len(df[col].unique())

num_total_values = len(df[col])

if num_unique_values / num_total_values < 0.5:

df[col] = df[col].astype('category')

for col in df.select_dtypes(include=['int64']).columns:

min_val = df[col].min()

max_val = df[col].max()

if min_val >= -128 and max_val <= 127:

df[col] = df[col].astype('int8')

elif min_val >= -32768 and max_val <= 32767:

df[col] = df[col].astype('int16')

print("\nZużycie pamięci po optymalizacji:")

print(df.info(memory_usage='deep'))

W praktyce taka optymalizacja potrafi zredukować zużycie RAM nawet o 50–70% bez zmiany logiki analizy.

NumPy – gdy dane są czysto numeryczne

Jeśli dane są wyłącznie liczbowe i można je powiązać z tablicą o stałym typie, NumPy daje ogromne korzyści pamięciowe:

- Tablice NumPy przechowują elementy w sposób zwarty, bez narzutu obiektowego Pythona.

- Są znacznie lżejsze niż listy list czy listy słowników.

- Idealne dla wektorowych obliczeń, statystyki, algorytmów numerycznych.

Dla miliona prostych rekordów numerycznych NumPy potrafi zużyć wielokrotnie mniej RAM niż równoważne struktury w czystym Pythonie.

Generatory – wyniki „na żądanie”

Generatory w Pythonie to sposób na przetwarzanie danych bez tworzenia pełnych list wyników. Dzięki słowu kluczowemu yield można zwracać kolejne rekordy tylko wtedy, gdy są potrzebne.

Przykład generatora wczytującego rekordy CSV:

import csv

def read_records_generator(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

reader = csv.reader(f)

next(reader) # Pomijamy nagłówek

for row in reader:

yield row

Użycie:

for record in read_records_generator('milion_rekordow.csv'):

# Przetwarzamy rekord

pass

Dzięki temu:

- Nie tworzysz ogromnej listy rekordów w pamięci.

- Dane są „produkowalne” na bieżąco i natychmiast przetwarzane.

- Łatwo łączyć generatory z innymi funkcjami tworząc pipeliny przetwarzania.

Usuwanie zbędnych obiektów i wykorzystanie __slots__

Przy dużych ilościach danych warto również zadbać o to, by:

- Na bieżąco usuwać niepotrzebne obiekty:

del nazwa_zmiennejusuwa referencję, co ułatwia garbage collectorowi zwolnienie pamięci.- Ograniczyć narzut instancji klas, jeśli tworzysz ich bardzo dużo:

class MyRecord:

__slots__ = ['id', 'name', 'value']

def __init__(self, id, name, value):

self.id = id

self.name = name

self.value = value

Zastosowanie __slots__:

- Zapobiega tworzeniu słownika

__dict__dla każdej instancji. - Zmniejsza narzut pamięci na pojedynczy obiekt.

- Ma sens przy tworzeniu setek tysięcy lub milionów obiektów reprezentujących rekordy.

Trzeba jednak pamiętać, że __slots__ ma ograniczenia – nie można swobodnie dodawać nowych atrybutów, a dziedziczenie bywa mniej elastyczne.

Jak oszacować i zmierzyć zużycie pamięci przy milionie rekordów

Zanim napiszesz pełny skrypt, warto oszacować zapotrzebowanie na pamięć i nauczyć się je mierzyć. Pozwoli to uniknąć bolesnych niespodzianek podczas produkcyjnego uruchomienia.

Szacowanie „na oko”: od surowych danych do obiektów Pythona

Prosty model szacowania może wyglądać tak:

-

Rozmiar surowego rekordu

Załóż, że typowy rekord CSV po zsumowaniu długości pól ma np. 100 bajtów.

Milion rekordów →100 bajtów * 1 000 000 = 100 000 000 bajtów ≈ 100 MB. -

Narzut Pythona

Obiekty Pythona są większe niż surowe bajty: - Reprezentacja danych w postaci listy słowników, listy stringów lub pełnego DataFrame może wymagać 5–20 razy więcej pamięci niż rozmiar pliku.

-

100 MB surowych danych może się zamienić w 500 MB, 1 GB, a nawet 2 GB RAM.

-

Dodatkowy narzut środowiska

Interpreter, załadowane biblioteki, struktury pomocnicze i zmienne tymczasowe również zajmują miejsce.

W praktyce warto przyjąć duży margines bezpieczeństwa. Jeśli z obliczeń wyjdzie 500 MB, przygotuj się raczej na 1–2 GB.

Narzędzia do realnego profilowania pamięci

Zamiast zgadywać, lepiej realnie zmierzyć, ile RAM pochłania Twój skrypt. Python oferuje kilka przydatnych narzędzi.

sys.getsizeof() – szybki pogląd na rozmiar obiektu

Funkcja sys.getsizeof() zwraca rozmiar obiektu w bajtach:

import sys

my_list = [i for i in range(1000)]

my_dict = {f'key_{i}': i for i in range(1000)}

print(f"Rozmiar listy: {sys.getsizeof(my_list)} bajtów")

print(f"Rozmiar słownika: {sys.getsizeof(my_dict)} bajtów")

Ważne ograniczenie: funkcja nie uwzględnia rozmiaru obiektów zagnieżdżonych, tylko sam „kontener”. Do pełniejszej analizy lepiej użyć dedykowanych bibliotek.

memory_profiler – profilowanie linii po linii

Biblioteka memory_profiler pozwala sprawdzić, które linie kodu zużywają najwięcej pamięci. Po instalacji (pip install memory_profiler) możesz profilować funkcje:

from memory_profiler import profile

@profile

def my_function():

a = [1] * (10 ** 6)

b = [2] * (2 * 10 ** 6)

del b

return a

if __name__ == '__main__':

my_function()

Uruchomiony z python -m memory_profiler profiler_example.py:

- Pokaże zużycie pamięci przed i po każdej linii w oznaczonej funkcji.

- Ułatwi wykrycie miejsc, w których tworzone są duże struktury danych.

- Pomoże zidentyfikować niepotrzebne kopie lub „wypływy” pamięci.

Pympler i narzędzia systemowe

Dla bardziej zaawansowanej analizy pamięci można sięgnąć po:

- Pympler (

pip install pympler): - Moduł

asizeofpozwala dokładniej oszacować rozmiar obiektu wraz z referencjami. - Można też monitorować ewolucję zużycia pamięci w czasie.

- Narzędzia systemowe:

toplubhtop(Linux/macOS) oraz Menedżer Zadań (Windows) pokażą całkowite zużycie RAM przez proces Pythona.- Przydatne, aby zobaczyć „z lotu ptaka”, czy skrypt zbliża się do granic możliwości maszyny.

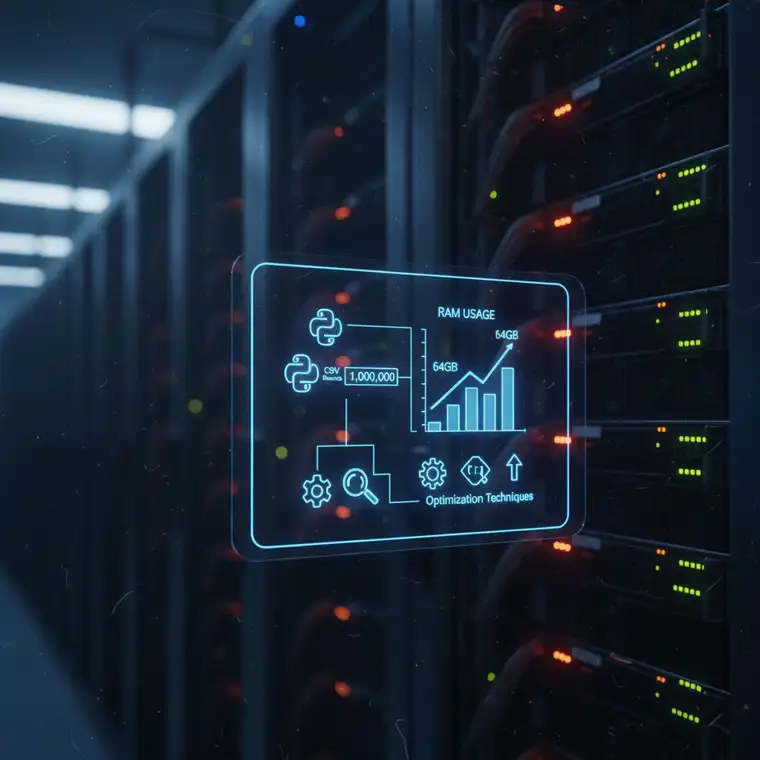

Przykład: milion transakcji w CSV i różne scenariusze

Załóżmy, że mamy plik transactions.csv z milionem rekordów. Każdy rekord wygląda następująco:

transaction_id, customer_id, product_name, category, amount, timestamp

Przyjmijmy, że średnio każdy rekord zajmuje około 150 bajtów (po uwzględnieniu długości stringów i formatów):

- 1 000 000 rekordów * 150 bajtów = 150 000 000 bajtów ≈ 143 MB surowych danych CSV.

Scenariusz 1: Naiwne ładowanie wszystkiego do listy słowników

import csv

import sys

def load_all_to_memory(file_path):

records = []

with open(file_path, 'r', encoding='utf-8') as f:

reader = csv.DictReader(f)

for row in reader:

records.append(row)

print(f"Wczytano {len(records)} rekordów.")

print(f"Rozmiar listy słowników w pamięci: {sys.getsizeof(records) / (1024**2):.2f} MB")

return records

W tym podejściu:

- 143 MB surowych danych może zająć 1–2 GB RAM, a czasem więcej.

sys.getsizeof(records)pokaże tylko część prawdy (lista), a nie wszystkie wewnętrzne słowniki.- Na słabszych maszynach grozi to

MemoryErrorlub intensywnym „swapowaniem”.

To najprostsza w implementacji, ale często najgorsza pod względem pamięci metoda pracy z milionem rekordów CSV.

Scenariusz 2: Pandas z chunksize i optymalizacją typów

Lepszym rozwiązaniem jest użycie Pandas w trybie „chunk‑by‑chunk” i świadome zarządzanie typami:

import pandas as pd

import numpy as np

def process_with_pandas_optimized(file_path, chunk_size=100000):

all_chunks_processed_data = [] # Opcjonalnie, jeśli chcesz gromadzić wyniki

dtype_optimization = {

'transaction_id': 'int32',

'customer_id': 'int32',

'product_name': 'category',

'category': 'category',

'amount': 'float32',

'timestamp': 'datetime64[ns]'

}

print("Rozpoczynam przetwarzanie z Pandas chunk-by-chunk...")

for i, chunk in enumerate(pd.read_csv(file_path, chunksize=chunk_size, dtype=dtype_optimization)):

for col in ['product_name', 'category']:

if col in chunk.columns and chunk[col].dtype == 'object':

chunk[col] = chunk[col].astype('category')

# Przetwarzanie chunka, np. agregacje, filtrowanie

print(

f"Przetworzono chunk {i+1}. "

f"Aktualne zużycie pamięci przez chunk: "

f"{chunk.memory_usage(deep=True).sum() / (1024**2):.2f} MB"

)

print("Zakończono przetwarzanie danych.")

W takim scenariuszu:

- W pamięci znajduje się typowo jeden chunk (np. 100 000 rekordów).

- Jeden fragment może zajmować rzędu kilkudziesięciu MB, w zależności od danych.

- Całkowite zużycie RAM jest wtedy mniej zależne od wielkości pliku, a bardziej od rozmiaru pojedynczego chunka.

Podsumowanie: ile RAM faktycznie potrzebuje skrypt Python dla miliona rekordów CSV?

Na pytanie, ile pamięci RAM potrzebuje skrypt Python przetwarzający milion rekordów CSV, nie da się odpowiedzieć jedną liczbą. Wszystko „zależy” od:

- Struktury danych (liczba kolumn, długość stringów, typy).

- Sposobu ładowania (wszystko naraz vs. strumieniowo).

- Używanych struktur danych i bibliotek (listy, słowniki, Pandas, NumPy).

Najważniejsze wnioski:

- Unikaj ładowania całego pliku do pamięci, jeśli nie jest to konieczne. Przetwarzanie strumieniowe i generatory to najprostsza droga do oszczędności RAM.

- Korzystaj z Pandas świadomie:

- Używaj

chunksize, aby nie trzymać w pamięci całego DataFrame. - Optymalizuj typy danych (

category,int8,float32) dla dużych tabel. - Regularnie profiluj i monitoruj pamięć:

- Szacuj wielkość danych „na oko”, ale potem potwierdzaj pomiary narzędziami (

memory_profiler,Pympler, narzędzia systemowe). - Eksperymentuj na mniejszych próbkach:

- Uruchom prototyp na części danych, sprawdź zużycie RAM i dopiero potem skaluj na cały plik.

Dzięki tym technikom możesz sprawić, że Twój skrypt Python bez problemu poradzi sobie nie tylko z milionem rekordów CSV, ale również z wielokrotnie większymi zbiorami – bez zatykania pamięci i bez niekontrolowanych błędów związanych z RAM.